인텔, 세계 최대 뉴로모픽 시스템 공개

컨텐츠 정보

- 조회

- 0 추천

- 목록

본문

인텔은 세계 최대 뉴로모픽 시스템을 발표했다. 코드명 '할라 포인트(Hala Point)'인 이 대규모 뉴로모픽 시스템은 최초로 샌디아 국립 연구소(Sandia National Laboratories)에 구축되었으며, 인텔 로이히 2(Loihi 2) 프로세서를 활용해 미래의 뇌 구조를 모방한 AI 연구 지원 및 현재 AI의 효율성 및 지속가능성과 관련된 과제를 해결하는 것을 목표로 하고 있다. 할라 포인트는 아키텍처 개선을 통해 인텔의 1세대 대규모 연구 시스템인 포호이키 스프링스(Pohoiki Springs)를 발전시켰으며 아키텍처 개선을 통해 뉴런 용량을 10배 이상 늘리고 최대 12배까지 성능을 향상시켰다.

인텔 랩스(Intel Labs)의 뉴로모픽 컴퓨팅 랩을 담당하는 마이크 데이비스(Mike Davies) 디렉터는 "오늘날 AI 모델의 컴퓨팅 비용은 지속 불가능한 속도로 증가하고 있다. 업계에는 확장이 가능한 근본적으로 새로운 접근 방식이 필요하다"라며 "이러한 이유로 인텔은 딥 러닝 효율성과 뇌와 유사한 새로운 학습 및 최적화 기능을 결합해 할라 포인트를 개발했다. 할라 포인트를 통한 연구가 대규모 AI 기술의 효율성과 적응성을 발전시킬 수 있기를 기대한다"라고 밝혔다.

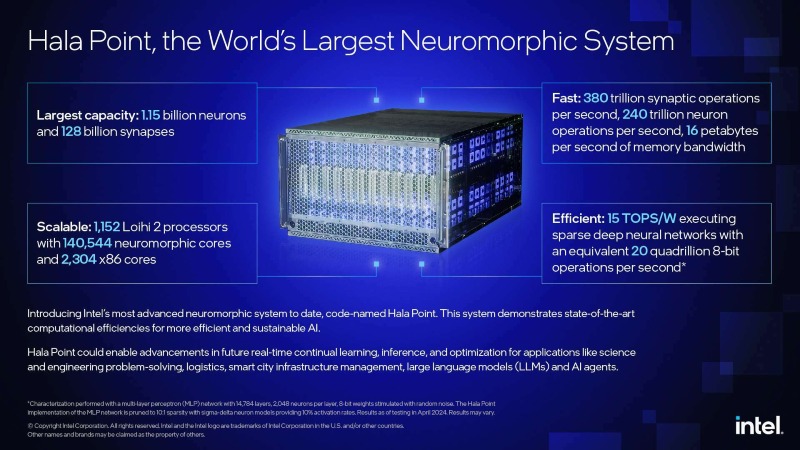

할라 포인트는 주로 사용되는(메인스트림) AI 워크로드에 적용 시 최첨단의 컴퓨팅 효율성을 입증한 최초의 대규모 뉴로모픽 시스템이다. 특성 분석 결과, 기존 심층 신경망을 실행할 때 와트 당 15 TOPS/w 8-비트 연산 처리(TOPS는 초당 수행할 수 있는 단위 연산으로, 1 TOPS는 1초당 10억 단위 연산 수행)를 초과하는 효율성으로, 초당 최대 20경 연산, 즉 20페타옵스(petaops)를 지원할 수 있는 것으로 나타났다. 이는 GPU 및 CPU 기반 아키텍처가 달성한 수준에 필적하거나 이를 능가하는 수치다. 할라 포인트의 고유한 기능은 과학 및 엔지니어링 문제 해결, 물류, 스마트 시티 인프라 관리, LLM(대형 언어 모델) 및 AI 에이전트와 같은 AI 애플리케이션을 위한 실시간 연속 학습을 가능하게 할 수 있다.

샌디아 국립 연구소의 연구원들은 첨단 두뇌 규모 컴퓨팅 연구에 할라 포인트를 사용할 계획이다. 이 연구소는 장치 물리학, 컴퓨터 아키텍처, 컴퓨터 과학 및 정보학 분야의 과학적 컴퓨팅 문제를 해결하는 데 중심을 둘 예정이다.

샌디아 국립 연구소의 크레이그 빈야드(Craig Vineyard) 할라 포인트 팀장은 "할라 포인트를 활용하며 샌디아 팀의 연산 및 과학적 모델링 문제를 해결 능력이 향상되었다. 이 규모의 시스템으로 연구를 수행하면 상업에서 국방, 기초 과학에 이르기까지 다양한 분야에서 AI의 진화에 발맞출 수 있을 것이다"라고 밝혔다.

현재 할라 포인트는 미래 상용 시스템의 기능을 향상시킬 연구용 프로토타입이다. 인텔은 이러한 시사점들을 통해 LLM이 새로운 데이터로부터 지속적으로 학습할 수 있는 능력과 같은 실질적인 발전으로 이어질 것으로 기대하고 있다. 이러한 발전은 광범위한 AI 배포 시 지속 불가능한 수준의 모델 훈련 부담을 크게 줄일 것으로 기대해 볼 수 있다.

딥 러닝 모델을 수조 개의 매개변수로 확장하는 최근 추세로 인해 AI의 지속 가능성 문제가 심각해지고 있으며 최저 레벨의 하드웨어 아키텍처에서 혁신의 필요성이 강조되고 있다. 뉴로모픽 컴퓨팅(Neuromorphic Computing)은 메모리와 컴퓨팅을 고도로 세분화된 병렬 처리로 통합하여 데이터 이동을 최소화하는 신경과학적 인사이트를 활용한 근본적으로 새로운 접근 방식이다. 이번 달에 개최된 ICASSP(International Conference on Acoustics, Speech, and Signal Processing)에서 발표된 결과에서 로이히 2는 새로운 소규모 엣지 워크로드의 효율성, 속도 및 적응성에서 수 배의 향상을 보여주었다.

이전 모델인 포호이키 스프링스에서 수많은 개선을 거쳐 발전한 할라 포인트는 이제 메인스트림 기존 딥 러닝 모델, 특히 영상, 음성, 무선 통신과 같은 실시간 워크로드를 처리하는 주류 기존 딥 러닝 모델에 뉴로모픽 성능과 효율성 향상을 제공한다. 예를 들어, 에릭슨 리서치(Ericsson Research)는 올해 MWC(모바일 월드 콩그레스)에서 발표한 것처럼 통신 인프라 효율성을 최적화하기 위해 로이히 2를 적용하고 있다.

할라 포인트의 기반이 되는 로이히 2 뉴로모픽 프로세서는 비동기식, 이벤트 기반 SNN(spiking neural networks), 통합 메모리 및 컴퓨팅, 희소하고 지속적으로 변화하는 연결(sparse and continuously changing connections) 등과 같은 뇌구조를 모방한 컴퓨팅 원리를 적용하여 에너지 소비 및 성능을 대폭 향상시켰다. 뉴런은 메모리를 통해 통신하는 대신 서로 직접 통신하므로 전체 전력 소비가 적다.

할라 포인트는 전자레인지 크기의 6랙 유닛 데이터 센터 섀시에 인텔 4 프로세스 노드에서 생산된 1,152개의 로이히 2 프로세서를 패키징 했다. 이 시스템은 최대 2,600와트의 전력을 소비하는 140,544개의 뉴로모픽 처리 코어에 분산된 최대 11억 5천만 개의 뉴런과 1,280억 개의 시냅스를 지원한다. 또한 이 시스템에는 보조 연산을 위한 2,300개 이상의 내장형 x86 프로세서가 포함되어 있다.

할라 포인트는 프로세싱, 메모리, 통신 채널을 대규모 병렬화된 패브릭에 통합하여 총 16 PB/s(초당 페타바이트)의 메모리 대역폭, 3.5 PB/s의 코어 간 통신 대역폭, 5 TB/s의 칩 간 통신 대역폭을 제공한다. 이 시스템은 초당 380조 개 이상의 8비트 시냅스와 240조 개 이상의 뉴런 연산을 처리할 수 있다.

생체에서 영감을 얻은 스파이크 신경망 모델에 적용된 이 시스템은 인간의 뇌보다 20배 빠른 11억 5천만 개의 뉴런을 최대 용량으로 실행할 수 있으며, 더 낮은 용량에서는 최대 200배 빠른 속도로 실행할 수 있다. 할라 포인트는 신경과학 모델링 용은 아니지만, 올빼미 뇌나 카푸친 원숭이의 피질과 거의 동일한 수준의 뉴런 용량을 갖추고 있다.

로이히 기반 시스템은 기존 CPU 및 GPU 아키텍처보다 최대 50배 빠른 속도로 100배 적은 에너지를 사용해 AI 추론을 수행하고 최적화 문제를 해결할 수 있다. 최대 10:1의 희소 연결과 이벤트 중심 활동을 활용함으로써 할라 포인트가 보여준 초기 결과에 따르면 이 시스템은 입력 데이터를 일괄적으로 수집할 필요 없이 15 TOPS/W2의 높은 심층 신경망 효율성을 달성할 수 있으며, 이는 카메라의 영상처럼 실시간으로 도착하는 데이터의 처리를 상당히 지연시키는 GPU의 일반적인 최적화 방식이다. 아직 연구 단계에 있지만, 지속적인 학습이 가능한 미래의 뉴로모픽 LLM은 계속 증가하는 데이터 세트를 주기적으로 재학습할 필요가 없어 기가와트-시(gigawatt-hours)의 에너지를 절약할 수 있을 것으로 보인다.